Waarom nauwkeurige algoritmes er toch vaak naast zitten

- 07 september 2023

Bijna dagelijks komen we claims tegen over geweldige AI-systemen die heel accuraat zouden zijn en de oplossing bieden voor een veelheid aan problemen. Toch zien we in de praktijk veel fouten, met vaak grote gevolgen. Kloppen die claims dan niet? Mogelijk, maar de manier waarop wij als mensen omgaan met kansen en statistiek speelt ook zeker een rol.

Lotte legde een paar weken geleden al uit waarom gezichtsherkenning in voetbalstadions überhaupt een slecht idee isDe opinie van Lotte verscheen in Trouw en lees je hier terug.. Eén van de vele argumenten tegen de inzet van gezichtsherkenning is dat de systemen nog veel fouten maken. Betekent dit dan dat we simpelweg betere algoritmes moeten bouwen? Even zoeken op internet leert ons dat moderne gezichtsherkenning in sommige tests maar liefst meer dan 99% accuraat is. Wow, indrukwekkend zou je denken! Over welke fouten hebben we het dan en is die 1% nou echt een probleem? Om daar goed antwoord op te geven maken we hierbij een klein uitstapje naar de wereld van medische statistiek.

De Medische Test Paradox

Stel, bij een reguliere bloedtest komt naar voren dat je een ernstige en zeldzame ziekte te pakken hebt. De test die is afgenomen is maar liefst 99% accuraat! Natuurlijk maak je je direct heel veel zorgen. Je huisarts probeert je echter gerust te stellen. Met 99% accuraatheid geeft 1 op de 100 tests immers een foute uitslag en de ziekte komt weinig voor. Slechts 1 op de 1000 mensen heeft de ziekte. Je bent een beetje in de war, moet je je nu druk maken of niet?

Bij een zeldzame ziekte verwachten we veel meer fout-positieve dan echte positieve uitslagen. Dat wil dus zeggen dat er meer mensen zijn die positief testen terwijl ze de ziekte niet hebben dan mensen die positief testen terwijl ze de ziekte wel hebben. In dit voorbeeld zal het zo zijn dat die ene persoon op de 1000 mensen die de ziekte heeft ook met grote waarschijnlijkheid positief test. Hierbij geldt echter ook dat 10 mensen van de 1000 (namelijk 999 gezonde mensen maal 1%) óók positief testen zonder de ziekte. Deze uitslagen zijn echter fout-positief. Deze mensen hebben de ziekte dus niet.

Dit verschijnsel heet de Medische Test Paradox. Hoewel het geen echte logische of wiskundige paradox is, immers spreekt niks elkaar tegen, voelt het toch gek: een accurate test die het vooral bij het verkeerde eind heeft. Het geeft aan dat het belangrijk is om niet alleen te focussen op de test zelf, maar om ook goed te kijken naar de kans op een ziekte los van de uitkomst van de test. Daarom is het testen van mensen zonder symptomen of zonder andere aanleiding geen goed idee, dit verhoogt immers de kans op fouten.

Fouten met Kunstmatige Intelligentie

Natuurlijk komt deze statistische ‘paradox’ niet alleen voor bij medische tests. Elk proces dat naalden in een hooiberg probeert op te sporen is kwetsbaar. Of het nu gaat over een leraar die probeert plagiaat te vinden, een agent die denkt een verdachte te herkennen, of een moderator die auteursrechtelijk beschermde muziek van een platform moet weren. Juist omdat dit soort processen zeer veel tijd en moeite kosten wanneer mensen dit uitvoeren grijpen overheden en bedrijven hiervoor steeds vaker naar AI.

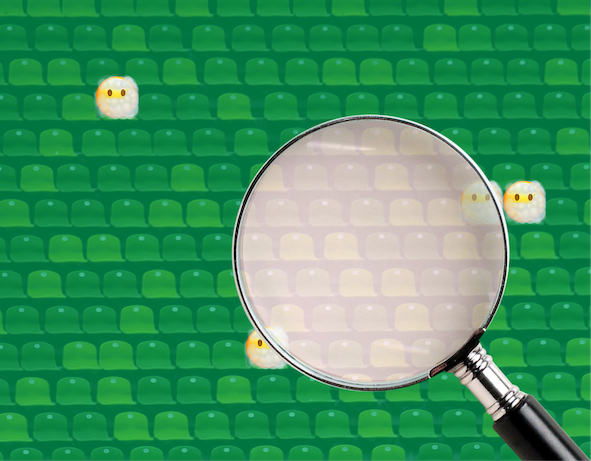

Laten we eens kijken welke uitkomsten een gezichtsherkenningsalgoritme met 99% accuraatheid zou hebben wanneer het wordt ingezet om stadionverboden te handhaven. Van 50.000 bezoekers aan een stadion is volgens KNVB-directeur Marianne van Leeuwen maar 1% een probleem, oftewel 500 bezoekers, en zijn de overige 49.500 dat niet. Het algoritme zal 500 maal 99% = 495 van deze probleembezoekers er uit vissen. Dat klinkt best aardig, maar het algoritme wordt ingezet op alle bezoekers. Er zullen dus van de zich goed gedragende voetbalfans ook 49.500 maal 1% = 495 onterecht door de beveiliging worden tegengehouden!

De Medische Test Paradox is natuurlijk ook een probleem zonder AI, maar toch zien we dat AI het probleem vergroot. AI komt vaak met specifieke nauwkeurigheidsclaims van de ontwikkelaars die heel goed klinken. Dit verlegt de focus van de effecten naar het proces. Bij handmatige processen zullen we sneller kijken naar de uitkomsten: hoeveel fouten zijn er gemaakt?

Daarbij komt dat we de magische zwarte doos die door programmeurs is ontwikkeld vaak blind vertrouwen. Waar we het werk van een collega misschien dubbel checken en zo fouten ondervangen voor ze een effect hebben, zullen we de uitkomst van een geavanceerd algoritme snel als waarheid aannemenBogert, Schecter, en Watson (2021) lieten bijvoorbeeld zien dat mensen een algoritme meer vertrouwden dan de gemiddelde inschatting van een grote groep.. Daarnaast kunnen we AI domweg op iedereen inzetten zonder significante extra kosten (in termen van tijd en geld), wat net zoals bij medisch testen zonder symptomen tot meer fouten zal leiden. Handmatige processen moeten selectiever worden toegepast en komen vaak met een plicht om beslissingen te kunnen motiveren.

Het belang van context

Kunnen we dan nooit iets doen aan zeldzame verschijnselen? Net als bij medische tests is vooral context belangrijk. Tests voor zeldzame ziektes zijn nog steeds heel nuttig als we ze combineren met andere informatie. Heb je verschijnselen? Zit de ziekte in de familie? In die gevallen is je kans op de ziekte niet zo klein als dat die is voor andere mensen en is het gevaar van fout-positieve dus kleiner.

We moeten af van de gewoonte waarin we ons alleen dood staren op hoe goed technologie werkt en wat het technisch gezien zou kunnen. De Medische Test Paradox is een van de vele dingen die mis gaan als we de maatschappelijke context niet mee nemen bij het gebruik van technologie. Er is zeker plek voor AI in onze samenleving, maar de focus moet zijn op de samenleving en niet op de AI.